Google TPUがAIチップ市場の覇権を握る?NVIDIA一強体制を揺るがすコスト革命

【この記事にはPRを含む場合があります】

最近、AI業界でとてつもなく大きな地殻変動が起きています。それは、長らくAIチップの「絶対王者」として君臨してきたNVIDIA(エヌビディア)の牙城が、ついに揺らぎ始めているというニュースです。その震源地こそ、Google(グーグル)が独自に開発したAI専用チップ、「TPU(Tensor Processing Unit)」です。

Googleの株価が上昇する一方で、NVIDIAの株価が下落するなど、市場のセンチメントが逆相関の関係にあるかのような動きも見られます。特にMeta(メタ)やOpenAI(オープンAI)、Anthropic(アンスロピック)といったAIの最前線を走る企業が、NVIDIAへの依存を減らすため、GoogleのTPUの導入を検討・実行しているという事実は、AI業界における「NVIDIA一強」の時代が終わるかもしれないという大きな期待を生んでいます。

この競争の激化は、AIを開発する企業にとってコスト削減と性能向上という大きなメリットをもたらします。普段からChatGPT(チャットGPT)やGemini(ジェミニ)を使っている方も、これからAI技術の導入を考えている方も、このTPUがAIにもたらす変化を知ることは、未来のテクノロジーを理解する上で非常に重要です。

この記事では、AI業界の構造を根底から変えようとしているGoogle TPUとは何か、なぜGPU(Graphics Processing Unit)よりも効率が良いのか、そして、このTPUの登場がNVIDIAの独占体制を本当に終わらせることになるのかについて、専門的な情報を平易な言葉でわかりやすく解説していきます。この記事を読み終える頃には、AI業界の新しい潮流と、次に取るべき一歩が見えてくるはずです。

GPUとTPUの決定的違い:NVIDIAの牙城は崩れるのか

GPUとTPUは、どちらもAI計算の高速化に特化していますが、そのアーキテクチャ、汎用性、エコシステムにおいて決定的な違いがあり、これがNVIDIAとGoogleの競争の核心となっています。

GPUは元々、3Dゲームのグラフィックス処理のために生まれました。そのため、万能型のアクセラレータとして、画像処理、シミュレーション、金融計算など、あらゆる並列計算に対応できる汎用性を持っています。しかし、AI特有の計算だけを行う際には、グラフィック用の不要な回路に電力と場所を使ってしまうという「重たい荷物(アーキテクチャ上の荷物)」を抱えてしまい、電力効率が悪くなります。

一方、TPUは、最初からAI(行列演算)に特化するために設計されたASICです。そのため、グラフィックス用の機能など、AIに不要なものを一切捨て去ることで、特定のAIタスクにおいては圧倒的な効率を叩き出します。

NVIDIA一強の源泉「CUDAエコシステム」の壁

NVIDIAがAIチップ市場で90%以上のシェアを持つ「一強」体制を築いている最大の理由は、そのGPUの性能だけではなく、20年以上にわたり築き上げてきたCUDA(クーダ)というソフトウェアエコシステムにあります。

- 世界標準のソフトウェア基盤

ほぼ全てのAIワークロードはCUDAプラットフォーム上で開発されており、AIエンジニアにとって「母国語」のような存在です。 - 高すぎるスイッチングコスト

もし企業がGPUからTPUのようなASICに移行する場合、何百万行ものコードを書き直す必要があります。この柔軟性と移行のしやすさこそが、NVIDIAの築いた強固な「要塞」であり、TPUが市場を席巻する上での最大の障壁となっています。NVIDIAは、自社のチップはTPUのような特定用途向けチップよりも「高い性能、汎用性、交換可能性」を提供すると主張し、汎用性の高さを最大の武器としています。

TPUの強み:コストと電力効率、そしてスケーラビリティ

それでもTPUがNVIDIAの牙城を崩せる可能性があるのは、推論やトレーニングにおける驚異的なコストと電力効率があるからです。

MetaがTPUの導入を検討している最大の動機は、NVIDIAの最高性能GPUに比べて30%から50%のコスト削減が見込める経済的なメリットにあります。また、TPUv4のエコシステムは、同時代の他の専用ハードウェアと比較して、CO2排出量を約2分の1に削減できるほど電力効率に優れています。最新のTPU「Trillium」(v6e)は、前世代より67%もエネルギー効率が高いとされ、大規模なAIインフラを持続可能にスケールさせる鍵となります。

さらに、GoogleのTPUは、大規模な並列計算を可能にする独自の相互接続技術(インターコネクト)に優位性があります。Googleの光サーキットスイッチ(OCS)は、何千ものTPUを柔軟に接続し、9,216個のTPUを一つの超巨大なスーパーコンピューターのように機能させることが可能であり、このスケーラビリティはNVIDIAのシステムを上回る可能性があります。

NVIDIA一強は終わるのか?

短期的には、NVIDIAの独占は継続すると見られています。NVIDIAは、チップ性能、CUDAエコシステム、そしてTSMCの製造能力の大部分を押さえるサプライチェーンの優位性という、多層的な要塞を築いています。

しかし、中長期的には市場の多様化が進むことは確実です。TPUは、GPUの汎用性とは対照的に、LLMのトレーニングや推論、レコメンドシステムといった定型化された大規模ワークロードを高効率かつ低コストで処理するという、AI業界の新たなニーズに応えることで、NVIDIAの市場シェアを徐々に侵食していくでしょう。これは、GPU(汎用工場)とTPU/ASIC(専用ライン)が役割分担しながら共存する「マルチソース戦略」の時代へと移行することを意味します。

AIの計算を激変させる!Google TPUの基本

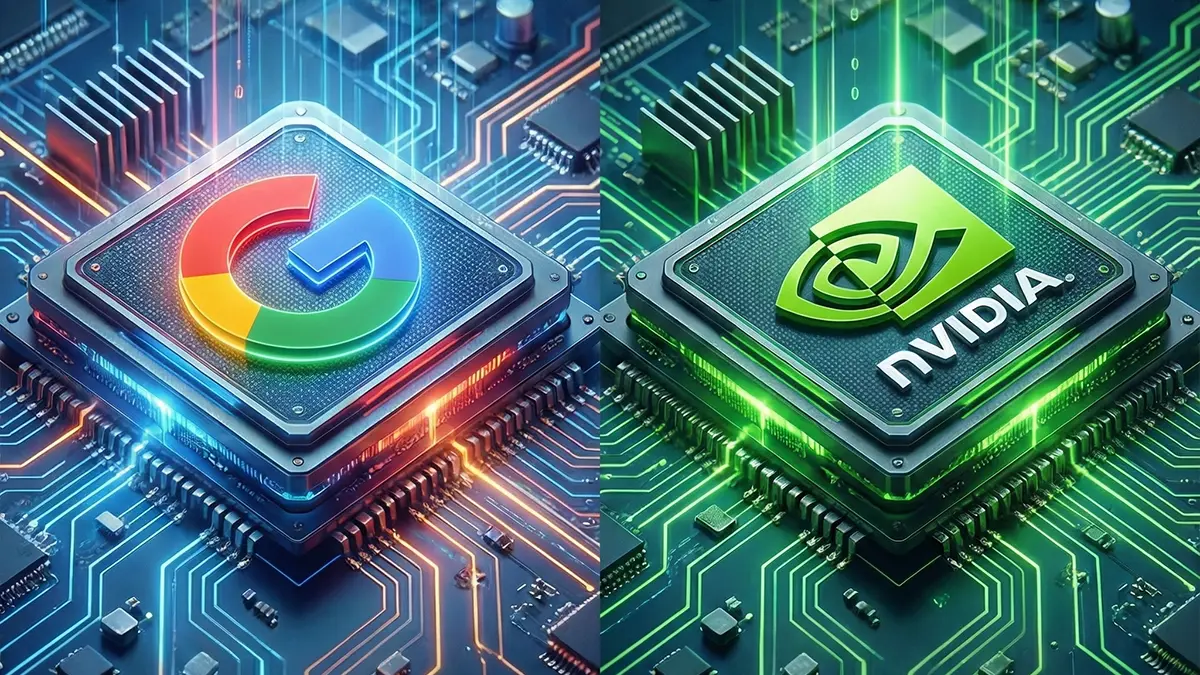

(出典:Google)

Google TPU(Tensor Processing Unit)とは、Googleが機械学習のワークロードを高速化するために独自に開発したAIアクセラレータであり、特定用途向け集積回路(ASIC: Application-Specific Integrated Circuit)の一種です。

TPUの開発は、AIが求める計算量が従来のハードウェアでは追いつかないという「危機的な状況」に対応するために始まりました。2013年頃、Googleは、もしAndroidユーザー全員が1日にたった3分間音声検索を使ったら、当時のデータセンターのコンピューターの数を2倍にする必要が生じると試算し、電力効率と処理能力の劇的な向上の必要性を痛感しました。この課題を解決するために、汎用性の高いCPUやGPUとは一線を画す、AIの計算に特化した専用チップとしてTPUが誕生したのです。

GoogleはTPUを2015年から社内で利用し始め、Google検索、Googleフォト、Google翻訳、そしてGoogleアシスタントなど、10億人以上のユーザーにサービスを提供しているGoogleのAIパワードアプリケーションのすべてを動かす心臓部となっています。

TPUでAIの何が変わる?

TPUの革新性は、その設計思想にあります。CPUやGPUが「何でも屋」の汎用的なプロセッサであるのに対し、TPUはニューラルネットワークの計算というたった一つの道を極めた「達人」のようなものです。この「ドメイン特化型アーキテクチャ」こそがゲームチェンジャーとなりました。

TPUは、主にAIモデルの学習(トレーニング)と、学習済みモデルの実行(推論:インファレンス)という2つのAIワークロードを加速するために最適化されています。

- 学習(トレーニング)

AIに膨大なデータを与えて知識を教え込む、一度きりの大変な作業です。TPUは、特に大規模で複雑な深層学習モデルや大規模言語モデル(LLM)のトレーニングに最適化されています。 - 推論(インファレンス)

学習した知識を使って、実際に質問に答えたり、画像を生成したりする、毎日ずっと続く仕事です。TPUは、この推論処理において圧倒的なコスト効率と処理速度を実現する点で注目されています。

TPUの核となる技術は「シストリックアレイ(Systolic Array)」です。これは、何千もの単純な計算機が完璧に同期した工場の組み立てラインのようにデータと計算をリズミカルに処理していく仕組みです。CPUやGPUのように計算のたびにメモリという「倉庫」からデータを取り出しに戻る(メモリアクセス)往復を劇的に減らすことで、待機時間がなくなり、ひたすら計算だけに集中できるため、圧倒的な計算効率を叩き出します。

初代TPU(V1)は、当時のCPUやGPUに比べて性能で15倍〜30倍、電力効率で30倍〜80倍という、桁違いの数字を記録しました。この驚異的な効率は、TPUがAI業界にもたらす最大の変化の一つです。

また、TPUには、特にレコメンデーションモデルで見られる、巨大な辞書のようなデータから必要な情報を探し出す「埋め込み処理」を加速するための「SparseCores(スパースコア)」という専用エンジンも搭載されています。これは、チップ面積や電力のわずか5%を占めるに過ぎませんが、レコメンドモデルの性能を劇的に引き上げることに成功しました。

Googleの最新TPUである「Ironwood(アイアンウッド)」(TPU v7)は、単体で4,614 TFLOP/sというピーク計算性能を誇り、超巨大なAIモデルの実行や、全てのユーザーに一瞬で応答するAIサービスを実現できるレベルです。Ironwoodは、256チップクラスターと9,216チップクラスターの2つの構成で提供される予定で、2025年第4四半期に一般提供開始予定です。

TPUは今どこで使われている?MetaやOpenAIの戦略

GoogleのTPUは、長らくGoogleの自社ワークロード専用でしたが、近年、Google Cloud Platform(GCP)を通じて外部企業へのレンタル提供が加速し、AI業界の主要プレイヤーが導入を検討・開始しています。

Googleの自社サービスにおけるTPUの活躍

Googleは、自社製品の検索、Gemini、Waymo(ウェイモ)など、AIを搭載した主要なアプリケーションの全てをTPUで動かしており、NVIDIAのGPUを自社のAIワークロードのために購入することなく、最先端のモデルを開発しています。

- Gemini(ジェミニ)

Googleが開発した最先端のAIモデル「Gemini 3 Pro」は、NVIDIAのGPUではなく、GoogleのTPUのみを使ってトレーニングされました。この事実は、TPUが大規模なAIトレーニングにおいてGPUと遜色ない、あるいはそれ以上の性能を発揮できることを証明し、NVIDIAへの懸念材料の一つとなりました。 - 動画生成AI

Googleの動画生成AI『Veo 3(ベオ スリー)』もTPUで動いており、テキストや画像から超高品質な音声付き動画を生成できます。

外部企業への提供とMeta、OpenAI、Anthropicの動向

Googleは、TPUチップそのものをMetaやAppleなどの大企業に大規模に販売する交渉を進めているという報道もあり、Google Cloud Platform(GCP)経由でのレンタル提供も積極的に行われています。

- Meta(メタ)

Metaは、2027年以降にデータセンターでGoogleのTPUを利用するため、数十億ドル規模の交渉を進めていると報じられています。Metaは、TPUを採用することで、NVIDIAへの依存を分散化し、特にレコメンデーションシステム(推奨アルゴリズム)のトレーニングにTPUの高パフォーマンスと30%〜50%のコスト削減というメリットを見出しています。 - Anthropic(アンスロピック)

ChatGPTの競合モデル「Claude(クロード)」を開発するAnthropicは、Googleと提携し、100万個ものTPUをリースする計画があると言われています。Anthropicは、日常的な推論タスクにGoogleのTPUを使うという明確な使い分けをしており、推論におけるTPUのコスパと処理能力を評価していることがわかります。 - OpenAI(オープンAI)

ChatGPTを開発したOpenAIも、GoogleのTPUの利用を開始したというニュースがありました。彼らの目的は、NVIDIAの高額なチップ代から解放されるためのコスト削減とマルチクラウド対応です。ただし、Googleは最新のTPUは自社で独占し、OpenAIには一世代前のものを使わせているようです。

AI業界のトップ企業がTPUを採用し始めたことは、NVIDIAの一強体制を揺るがす「ドミノ効果」を生み出す可能性があり、AI投資の健全な分散化と競争を促進すると期待されています。

TPUの製造はどこ?TSMCとBroadcomの役割

(出典:TSMC)

GoogleのTPUは、Googleがアーキテクチャ設計と仕様を行い、製造プロセスにはBroadcom(ブロードコム)とTSMC(台湾積体電路製造)が深く関わっています。

GoogleとBroadcomの強力な協力体制

TPUの知的財産(IP)はGoogleが所有していますが、TPUの製造については、Broadcomが共同開発者としての役割を担っています。

- Broadcomの役割

Broadcomは、Googleの設計と仕様を製造可能なシリコンに変換する役割を担っています。具体的には、SerDes高速インターフェースなどの独自技術の提供、ASIC設計の監修、そしてTSMCのようなサードパーティのファウンドリを介したチップの製造とパッケージングの管理を行っています。 - コスト効率の追求

Googleは、チップの頭脳部分(フロントエンド設計)を自社で行い、Broadcomには物理的な配置(バックエンド)のみを担当させることで、パートナーに支払うマージンを極限まで削り、コストを抑え込んでいると言われています。これにより、NVIDIAに多額の利益を払う必要がなくなり、競争上の優位性を獲得しています。

TPUの外部販売のニュースが報じられた際、Googleの株価だけでなく、TPUの製造を担うブロードコムの株価も急上昇しました。これは、TPUの需要拡大がブロードコムのビジネスのボリュームに直結すると市場が評価したためです。

TSMCの製造能力とNVIDIAのサプライチェーン

TPUの製造は、NVIDIAと同様にTSMCなどのファウンドリ(半導体受託製造企業)に委託されています。

しかし、現在、AIチップの製造においてはTSMCの生産能力が大きな制約となっており、NVIDIAは、このTSMCの製造能力のほぼ全てを自社のチップ製造のために確保しているという戦略的な優位性を持っています。GoogleがTPUを数百万個規模で販売しようとしても、「誰がそのチップを作るのか」という供給制約が、NVIDIAの牙城を崩す上で一つの大きな課題となっています。

TPUの未来:NVIDIAの牙城は完全に崩れるのか?

TPUの登場は、NVIDIAの独占体制に「大きな亀裂」を生み出しましたが、その未来はTPUの普及の壁と、AI市場の進化の方向性によって左右されます。

TPU普及の最大の壁:ロックインの恐怖

TPUが世界中でGPUのように普及するためには、いくつかの高い壁を乗り越える必要があります。

- CUDAエコシステム:AI開発者が長年慣れ親しんだNVIDIAのCUDAというソフトウェア基盤は、簡単に置き換えられません。GoogleはPyTorchやJAXなど他のフレームワークに対応する取り組み(XLAなど)を進めていますが、歴史的なライブラリやノウハウの蓄積においては、まだNVIDIAに勝てていません。

- クラウドの縛りとロックイン:NVIDIAのGPUは、AWS、Azure、GCPなどどのクラウドでも借りられますが、TPUは基本的にGoogle Cloud (GCP)内でしか使えません。企業は、TPUに完全に依存したコードを書いてしまうと、GoogleがTPUの利用料を大幅に引き上げた際に逃げ場がなくなるという「ベンダーロックインの恐怖」を抱くため、多少高くても汎用性と自由を買うNVIDIAを選ぶ傾向があります。

NVIDIAのジェンセン・ファンCEOは、TPUのようなASICが「特定のAIフレームワーク向けに設計されている」のに対し、NVIDIAは「より高い性能、汎用性、交換可能性」を提供すると強く主張しており、TPUの特化性を逆手にとって優位性を保とうとしています。

AI市場の進化とTPUのチャンス

しかし、AI市場の進化の方向性は、TPUに大きなチャンスをもたらしています。

- 推論市場の拡大

AIのトレーニング(学習)市場がいつか飽和すると予測される一方で、推論(日々の実行)の市場は、AIが実行される回数の多さから、訓練市場よりもはるかに大きくなると見られています。推論フェーズでは、速度とコスト効率が最も重要になり、TPUのコスパ最強という特性が活かされます。 - TPUの性能進化

NVIDIAのGPUがTPUの登場に刺激されて行列演算に特化する方向へ進化しているのと同様に、GoogleもTPUのアーキテクチャを継続的に進化させています。最新の「Ironwood v7」TPUは、単体チップの性能においてもNVIDIAの最新GPUと互角に渡り合えるレベルに達しており、メモリ容量もNVIDIAのBlackwell B200と同容量の192GBのHBMを搭載しています。

Googleは現在、TPUを自社専用の「秘密兵器」としてGCPの競争力を高めるために使うか、NVIDIAのように外部販売に舵を切り、AIチップメーカーとしての地位も確立するかという、会社の未来を左右する議論を社内で進めていると言われています。もしGoogleが本格的に外販に踏み切れば、AI業界の勢力図は劇的に変化する可能性があります。

AI業界の競争と進化:NVIDIA依存から脱却する未来へ

GoogleのTPUは、その登場と大手企業の採用によって、NVIDIAの一強支配を崩し、AI業界に競争とイノベーションをもたらしました。

TPUとは、AIの計算を専用の組み立てライン(シストリックアレイ)で処理することで、GPUの汎用的な設計に伴う「重い荷物」を捨て去り、圧倒的なコスト効率と電力効率を実現した、Googleの生存戦略が生んだ専用チップです。

MetaやAnthropic、OpenAIといったトップAI企業がTPUを採用し始めた背景には、NVIDIAの高額なチップ代から脱却し、推論処理など特定のワークロードを高効率で安く済ませるという、明確な経済的合理性があります。この動きは、AIインフラがGPU(汎用)とTPU/ASIC(専用)のハイブリッド艦隊によって構成される、マルチソース戦略の時代へと移行していることを示しています。

NVIDIAのCUDAエコシステムは依然として強固な「堀」であり、TPUがGPUを完全に置き換えることは当面ありません。しかし、AIの推論市場が爆発的に拡大する未来においては、TPUのコストと効率の優位性が、Googleに長期的な競争優位をもたらすでしょう。

AI業界は、NVIDIAとGoogleの「巨人同士の殴り合い」によって、さらなる技術革新へと加速していきます。この競争は、AIを使う私たちにとって、より速く、安く、高性能なAIサービスが生まれるという、大きな恩恵をもたらすでしょう。

AI業界の動向を追う上で、NVIDIAの汎用的な強さと、Google TPUの特化された効率性、この二つの拮抗した力の行方を見極めることが、未来のテクノロジーを理解する鍵となります。

みんなのらくらくマガジン 編集長 / 悟知(Satoshi)

SEOとAIの専門家。ガジェット/ゲーム/都市伝説好き。元バンドマン(作詞作曲)。SEO会社やEC運用の経験を活かし、「らくらく」をテーマに執筆。社内AI運用管理も担当。