CGLAとは?プレステ開発陣が挑む!消費電力9割減の日本発AIチップ

【この記事にはPRを含む場合があります】

「AIが進化するのは嬉しいけど、電力消費がすごいって聞くけど本当?」 「NVIDIAのGPU不足が話題だけど、日本企業にチャンスはないの?」

そんな疑問を持っていませんか?

ChatGPT (チャットGPT)やGemini(ジェミニ)などの生成AIが爆発的に普及する一方で、AIを動かすためのデータセンターの消費電力が世界的な問題になっています。

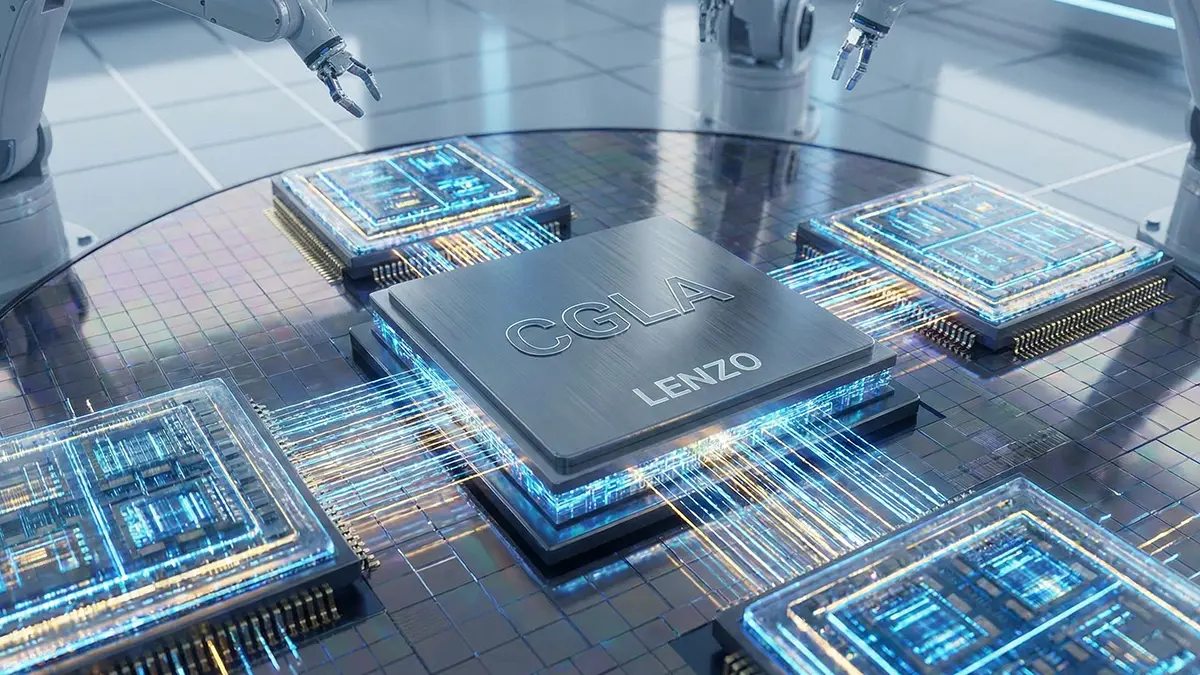

そんな中、かつて世界を熱狂させたゲーム機『PlayStation 2』や『PlayStation 3』の心臓部を作った日本の天才エンジニアたちが、AI業界の常識を覆す全く新しいチップ『CGLA』を開発し、世界中から注目を集めているのをご存知でしょうか?

なんと、現在のAI半導体の王者であるNVIDIA(エヌビディア)のGPUと比較して、消費電力を最大9割も削減できる可能性があるというのです。

そこでこの記事では、日本発のスタートアップ企業LENZO(レンゾ)が開発するCGLAとはどんな技術なのか、GPUやGoogleのTPUと何が違うのか、そして私たちの未来をどう変えるのかについて詳しくお伝えします。

CGLA(レンゾ)とは?プレステ開発陣が生んだ「消費電力9割減」の仕組み

(出典:LENZO株式会社)

CGLA (シージーエルエー)とは、「CoarseGrainedLinearArray(コース・グレインド・リニア・アレイ)」の略称で、AIの処理効率を極限まで高めるために設計された新しいアーキテクチャ(構造)のことです。

現在、AI業界ではNVIDIAのGPUが主流ですが、消費電力の増大が深刻な問題となっています。実は、現在のコンピュータは「計算」そのものよりも、データの「移動」に多くのエネルギーを使っているのです。

NVIDIA自身の研究でも、計算に使うエネルギー(20ピコジュール)よりも、チップ内でデータをわずか1mm移動させるエネルギー(26ピコジュール)の方が大きいことがわかっています。

CGLA を開発する日本発のスタートアップ『LENZO(レンゾ)』は、この「データの移動」を減らすことに着目しました。データをバケツリレーのようにスムーズに流す「データフロー型」という仕組みを採用することで、無駄な電力消費を最大9割も削減できる可能性があるのです。

プレステ開発陣とスパコン技術者のドリームチーム

この技術を支えているのは、かつて『PlayStation 2』や『PlayStation 3』のCPU開発に携わったエンジニアや、富士通でスーパーコンピューターを開発した技術者たちです。

限られた性能の中で最高のパフォーマンスを引き出すゲーム機の開発ノウハウが、AI半導体の世界で再び生かされようとしています。ネット上でも「ドリームチームだ」「日本半導体の逆襲」と大きな注目を集めています。

なぜ電力が9割も削減される?「移動」を減らす秘密

従来のCPUやGPUは「ノイマン型」と呼ばれ、計算する場所とデータを保存する場所(メモリ)が分かれています。料理に例えるなら、「まな板(計算機)」と「冷蔵庫(メモリ)」が離れている状態です。食材を切るたびに冷蔵庫まで往復するため、無駄なエネルギーを使います。

一方、CGLAは、計算ユニットと小さなメモリを一列(リニア)に並べ、隣の人にデータを渡すように処理を進めます。一度取り出したデータは、ラインの上を流れながら次々と加工されていくため、いちいち遠くのメモリに戻る必要がありません。

「データの移動距離」を物理的にゼロに近づける 。このシンプルな発想の転換こそが、劇的な電力削減の秘密なのです。

【比較】NVIDIA GPU・Google TPUと何が違う?最強の「いいとこ取り」構造

では、CGLAは、既存のNVIDIA GPUやGoogle TPUと比べて、具体的に何が優れているのでしょうか?それぞれの得意・不得意を比較してみましょう。

NVIDIA GPU:柔軟だが「燃費」が悪い

NVIDIA のGPUは、汎用性が高く、どんな計算でもこなせる万能選手です。しかし、構造上、メモリと計算機の間で頻繁にデータのやり取りが発生します(ノイマン型ボトルネック)。

大量のデータを並列処理するのは得意ですが、AIのモデルによっては効率が悪く、無駄な電力を食ってしまうことがあります。例えるなら、繊細な手術をするのに、巨大なハンマーを振り回しているような非効率さが生まれることがあるのです。

Google TPU:効率的だが「融通」が利かない

一方、Googleが開発したTPU(Tensor Processing Unit)は、AIの特定の計算(行列演算)に特化して、データをベルトコンベアのように流すことで効率化しています(シストリックアレイ)。

燃費は非常に良く、コストも抑えられますが、「決まった計算」しかできないという弱点があります。もしAIの流行が変わり、新しい計算方式が必要になった場合、TPUでは対応できなくなるリスクがあるのです。

CGLA:効率と柔軟性を両立する「いいとこ取り」

CGLA は、この両者の課題を解決する「いいとこ取り」を目指しています。

TPUのようにデータをスムーズに流して省エネを実現しつつ、データの通り道をソフトウェアで自由自在に組み替えられる(Configurable)点が最大の特徴です。

つまり、「GPUのような柔軟性」を持ちながら、「TPU並みの省エネ性能」を発揮できるのが、CGLAの強みなのです。技術者たちはこのポジションを「夢のようなポジション」と表現しています。

次世代AIにも対応可能?「構成可能」な柔軟性とCUDAの壁

AIの世界は進化が速く、今の常識が数年後には通用しなくなるかもしれません。 「せっかく専用チップを作っても、すぐに時代遅れになるのでは?」という懸念に対し、CGLAはその名の通り「Configurable(構成可能)」であることで答えを出しています。

AIモデルが変わっても「配線」を変えればOK

現在、生成AIの主流は「トランスフォーマー」という技術ですが、すでに「Mamba(マンバ)」などの新しいモデルも登場し始めています。

GoogleのTPUのような専用チップ(ASIC)は、計算方式が固定されているため、こうした変化に弱い側面があります。しかし、CGLAなら内部の回路のつなぎ方をソフト的にガチャっと組み替えることで、新しいAIモデルにも柔軟に対応できます。

ハードウェアを買い替えなくても、中身の構成を変えるだけで使い続けられる「寿命の長さ」も大きなメリットです。

最大の壁「CUDA」をどう乗り越えるか

もちろん、課題もあります。最大の壁は、NVIDIAが築き上げたソフトウェア環境『CUDA(クーダ)』の存在です。

世界中のAI開発者は、NVIDIAのGPUで動くことを前提とした「CUDA」というツールを使って開発をしています。いくらハードウェアが優秀でも、この使い慣れたツールが使えなければ普及しません。

LENZO は、まずは電力効率が最優先されるデータセンターの推論サーバーや、マイニングなどの特定の用途からシェアを広げ、実績を作っていく戦略のようです。クラウド事業者がNVIDIAへの依存を減らしたいと考えるタイミングで、CGLAが選択肢に入る可能性があります。

日本企業がAI業界を変える未来へ

NVIDIA が支配するAI帝国に対し、真正面から「省エネ」と「効率」という武器で挑む日本のLENZO。

消費電力9割削減 という技術は、単なるコスト削減だけでなく、地球規模のエネルギー問題を解決する鍵になるかもしれません。

かつて「技術大国」と呼ばれた日本のエンジニアたちが、AIという最先端のフィールドで再び世界を驚かせようとしています。TSMCでの製造も計画されており、実用化はすぐそこまで来ています。

「CGLA」という言葉、これからのニュースで目にする機会が増えるはずです。ぜひ覚えておいてくださいね!

みんなのらくらくマガジン 編集長 / 悟知(Satoshi)

SEOとAIの専門家。ガジェット/ゲーム/都市伝説好き。元バンドマン(作詞作曲)。SEO会社やEC運用の経験を活かし、「らくらく」をテーマに執筆。社内AI運用管理も担当。